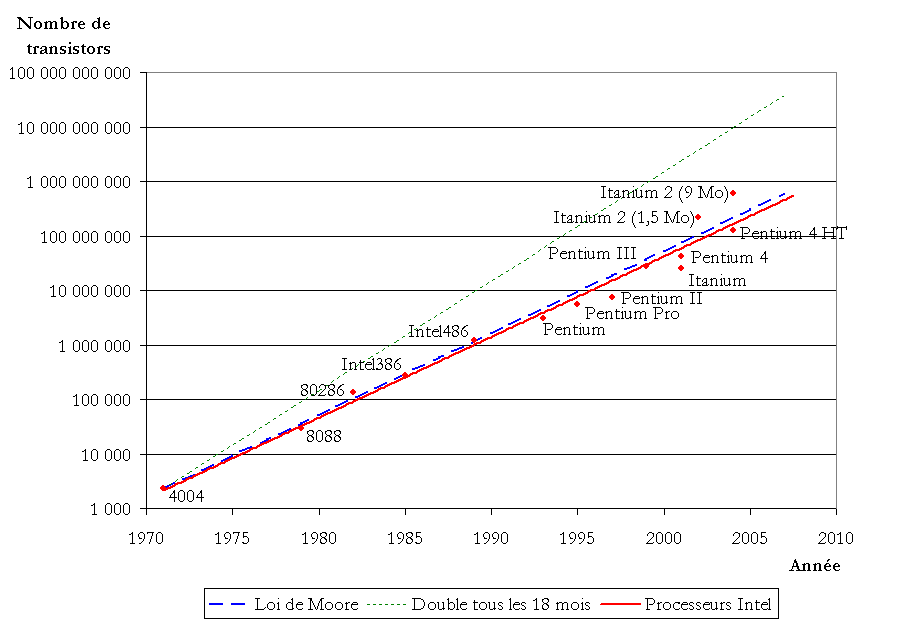

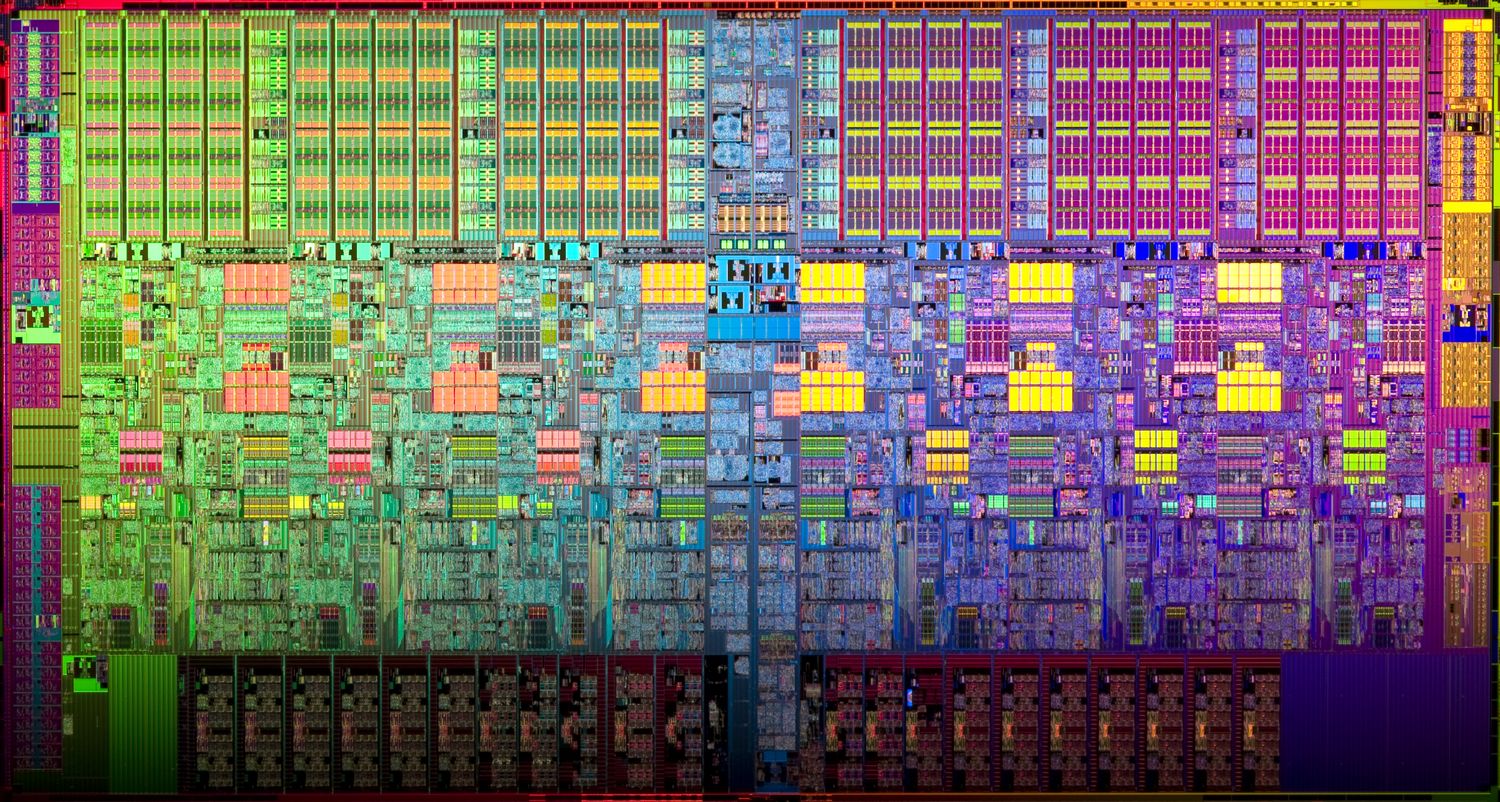

Pour ceux qui nous suivent depuis nos débuts en 2013 ou, qui auraient pris le train en route, impossible de ne pas remarquer que dans les différents billets de blog que nous rédigeons, certaines références reviennent très souvent. Des propos parfois répétitifs pour ne pas dire cycliques… La Loi de Moore en fait bien évidemment partie ! Exprimées en 1965, « la » ou plutôt, les Lois de Moore n’ont cessé de faire parler d’elles de manière houleuses ou enjouées, tout en ayant réussi à mettre finalement à peu près tout le monde d’accord. La plus célèbre des lois empiriques initiées par un certain Gordon Moore, cofondateur d’Intel en 1968, s’appuie un prévisionnel du doublement du nombre de transistors des microprocesseurs tous les 2 ans, grâce à une finesse de gravure sans cesse améliorée. Une loi réévaluée par son géniteur en 1997, indiquant que cette croissance exponentielle devrait se heurter en 2017 à un mur technologique, dû à la limite physique liée à la taille des atomes. Utilisée par l’industrie électronique, cette loi a servi de fil conducteur durant les 5 dernières décennies. À noter que la Loi de Moore s’est montrée tout à fait véridique entre 1971 et 2001, avec une augmentation du nombre de transistors multiplié par deux toutes les 1,96 années ayant pour résultante, une baisse significative du coût global des machines associé à une puissance perpétuellement à la hausse dans le domaine de l’informatique dans sa globalité. Toutefois un déclin est à souligner depuis 2015 avec une croissance en berne du nombre de transistors présent sur les puces au silicium… Une réalité tout à fait tangible qui met à mal cette loi empirique comme l’avait prédit Gordon Moore, en raison d’une taille minimale atteinte empêchant physiquement de descendre en finesse de gravure ou alors, de manière bien plus lente que ce que nous avions connu auparavant.

L’ère des Micropuces informatiques révolue

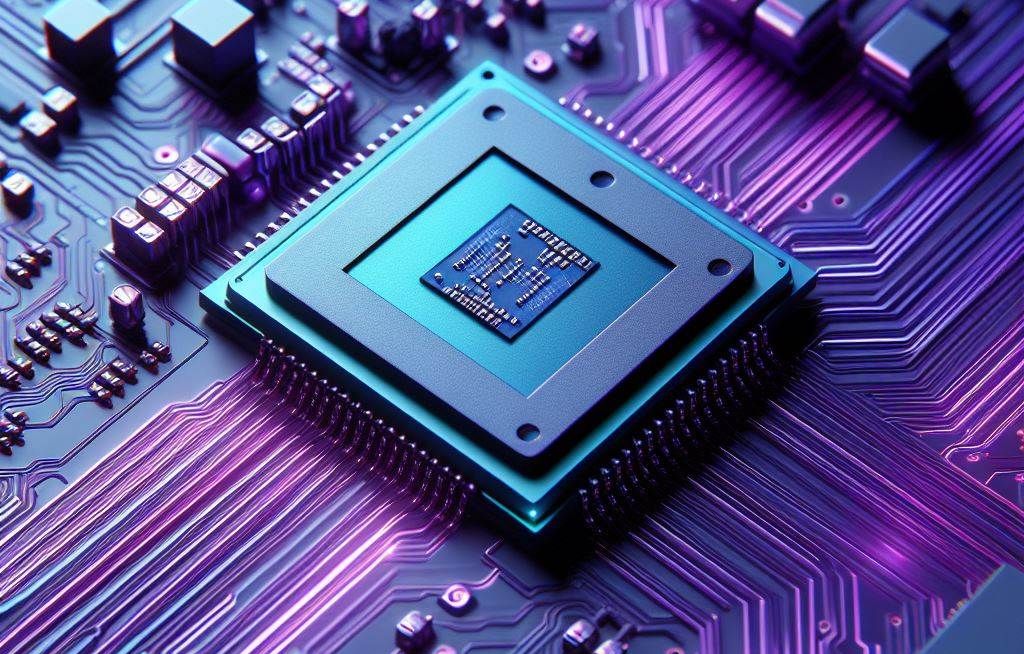

Si l’on se réfère à un article paru dans le « Wall Street journal » le 30 juillet dernier, il est notoire que si l’on souhaite continuer cette course effrénée à la puissance, il se devra de repartir à la hausse en matière de taille… La miniaturisation des processeurs et autres SoC ne laisse que peu de marge hélas. Il s’avère donc que d’autres méthodologies semblent se répandre tel l’empilement des puces de manière à créer selon le Wall Street Journal, des « mini-métropoles de silicium au cœur de notre monde électronique » Belle métaphore ! Ces différentes superpositions à outrance de puces imbriquées formant des « mégapuces » sont bel et bien une réalité tangible avec des exemples concrets présents au quotidien. Dévoilée au printemps 2022, la puce Apple « M1 Ultra » aux performances stratosphériques s’appuie sur un assemblage de deux puces M1 Max… Un tour de passe-passe rendant de plus en plus énergivores les processeurs. Ces assemblages se font grâce à une certaine finesse de gravure permettant de s’appuyer sur des liaisons en silicium et non, de manière cuivrée comme l’on peut l’observer sur une carte électronique. Une approche qui selon Intel, se montre totalement novatrice apportant rapidité et économie en opposition aux traditionnelles méthodes d’assemblage.

L’ère des Micropuces informatiques révolue | Conclusion : dirigerions nous vers la singularité technologique ?

En environnement de caméras de vidéosurveillance, l’utilisation massive de l’intelligence artificielle, l’usage de capteurs mégapixels toujours plus performants, la miniaturisation à outrance et la nécessité d’implémenté des couches de sécurité toujours plus importantes, demande des puissances de calculs bien plus élevées au fils des années ce qui de facto, devrait probablement nourrir cette croissance… Dirigerions-nous vers la singularité technologique ? Concept auquel le progrès ne serait plus lié à l’humain, mais seulement à l’œuvre des machines et de leur propre intelligence artificielle toujours plus évoluées. Un point où seules les machines pourraient concevoir d’autres machines plus puissantes qu’elles-mêmes. Nous ne sommes pas encore à ce point de non-retour et espérons ne jamais l’atteindre même si, bon nombre de scientifiques abordent ce sujet de manière pessimiste avec des conséquences tangibles sur nos modes de vie futurs. Ce type d’hypothèse nourri des débats houleux ou réalistes, abreuvé par une intelligence artificielle dépassant presque la fiction ce qui est bel et bien, une réalité tangible à ce jour. Un concept dont le débat aura été ouvert dès les années 50 et qui ne cesse d’être ravivé. En 2017, le « Future of Humanity Institute » a réuni quelques 360 chercheurs dans le domaine de l’IA. La moitié d’entre eux se seront mis d’accord sur le fait que l’intelligence artificielle aura surpassé l’humain dans toutes les tâches à l’horizon de 2067, pour mes 81 ans ! Glaçant !